注意力机制和自注意力机制区别_注意力机制和自注意力机制区别

*** 次数:1999998 已用完,请联系开发者***

久其软件:公司尚在研究DeepSeek提出的稀疏注意力机制专为超快长上下文训练与推理设计。贵司于今年2月10日在互动平台表示在大模型蒸馏方面,公司技术团队主要掌握采用软标签、注意力等蒸馏技术。请问贵司掌握的注意力蒸馏技术和DeepSeek提出的稀疏注意力机制有何异同之处?谢谢。公司回答表示:关于DeepSeek提出的稀疏注意...

ˇ△ˇ

AI绘画中,Transformer的“自注意力机制”有什么作用?Transformer的自注意力机制和位置编码发挥了关键作用。 AI绘图模型大量使用了自注意力机制训练,用于提取和生成更加准确符合文本提示的图片: 自注意力机制就像是一个超级聚光灯,能够照亮文本中最重要的信息。当我们阅读一段话时,自然会关注其中的关键词,而忽略不相关的部...

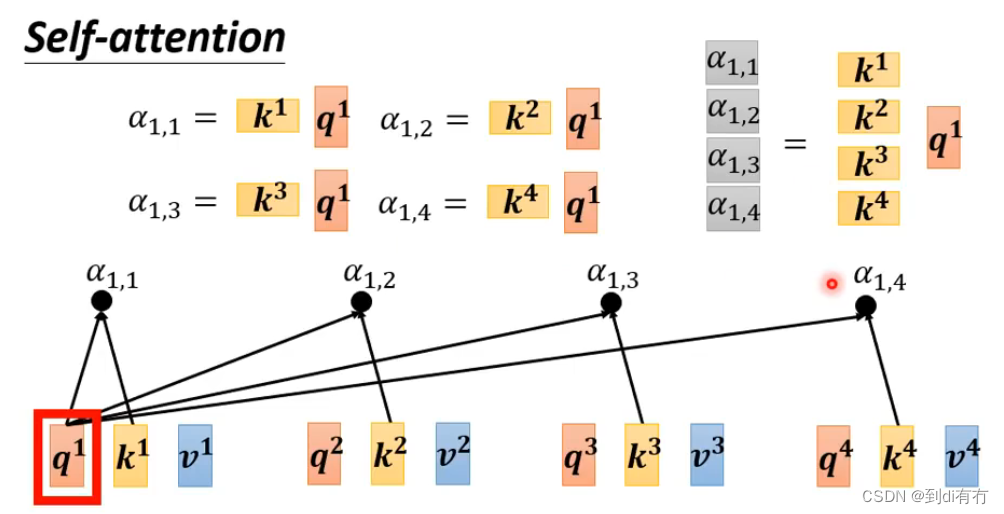

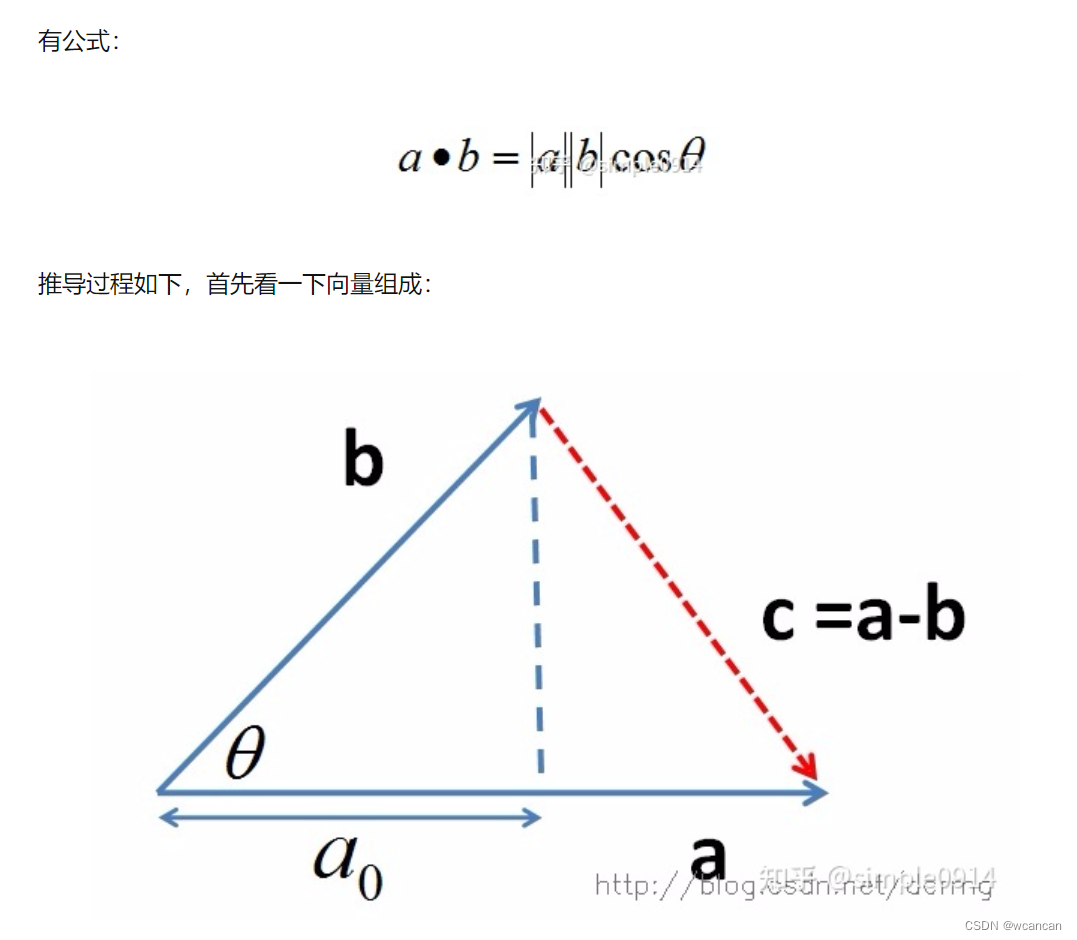

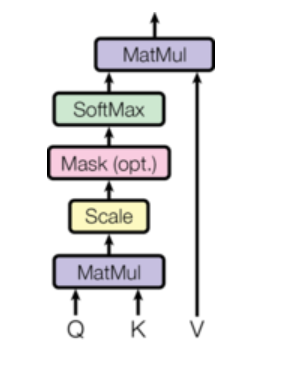

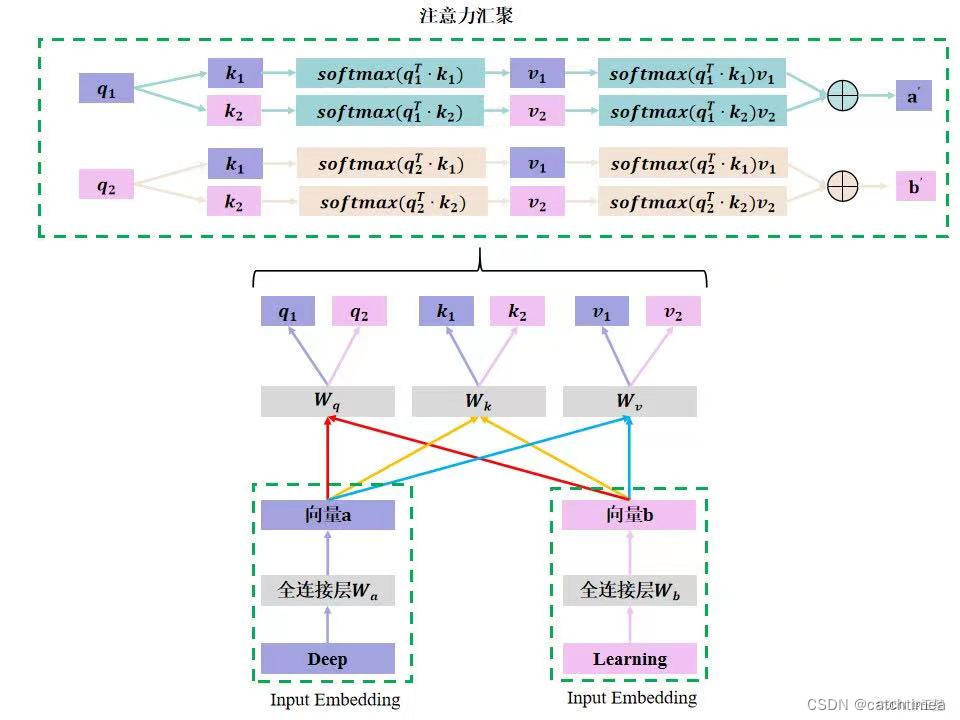

一文明白什么是自注意力机制,还不快来学自注意力(Self-Attention),也被称为内部注意力(Intra-Attention),是一种注意力机制,它允许模型在同一个序列内的不同位置之间进行直接的交互和关联。这种机制使得模型能够捕捉序列内部的长距离依赖关系,无论这些依赖关系的实际距离有多远。 在自注意力机制中,每个序列元素都会生成...

o(╯□╰)o

国网(山东)电动汽车服务申请基于概率稀疏自注意力机制的充电桩故障...本发明提出了一种基于概率稀疏自注意力机制的充电桩故障检测方法,属于充电桩技术领域,包括以下步骤:S1:对充电桩常见的故障种类进行模拟;S2:输入层将输入的电压值序列转化为模型的编码层可处理的高维向量;S3:模型的编码层通过自注意力机制得到不同输入变量之间的相关性得分...

海康威视获得发明专利授权:“一种自注意力机制计算方法、推理方法”证券之星消息,根据天眼查APP数据显示海康威视(002415)新获得一项发明专利授权,专利名为“一种自注意力机制计算方法、推理方法”,专利申请号为CN202410852330.7,授权日为2024年8月27日。专利摘要:本申请实施例提供了一种自注意力机制计算方法、推理方法,该方法包括:基于...

算法人生(20):从“自注意力机制”看“个人精力怎么管”自注意力和前馈网络层的计算:在编码器和解码器的每个层中,分别执行多头自注意力机制和全连接前馈网络的计算,以生成新的表示。最终输出... 并利用它们之间的相互作用来计算每个位置的注意力分数,然后根据这些分数对序列中的不同位置进行加权平均,从而获得每个位置的新表示。...

ˇωˇ ...申请基于注意力机制的电厂场景多模态数据协同校准专利,实现对不同...本发明公开了基于注意力机制的电厂场景多模态数据协同校准方法,涉及多模态数据处理技术领域,具体包括:对电厂场景进行全方位的监测和采集,针对不同的模态数据,采用相应的采集方式和设备、通过编码器对图像、视频和文本等不同模态数据进行特征提取、解码器采用注意力机制动...

⊙^⊙

...知识图谱和时序自注意力机制实现级联测试自动化,减少所耗费的工作量获得同一时刻的预测特征向量与特征向量的相似度,更新得到文本图谱映射模型;获取与待测试业务对应的约束向量输入更新后的文本图谱映射模型进行处理,得到测试请求报文图谱,解码得到测试报文用来测试。通过采用知识图谱和时序自注意力机制实现级联测试自动化,减少所耗费的工...

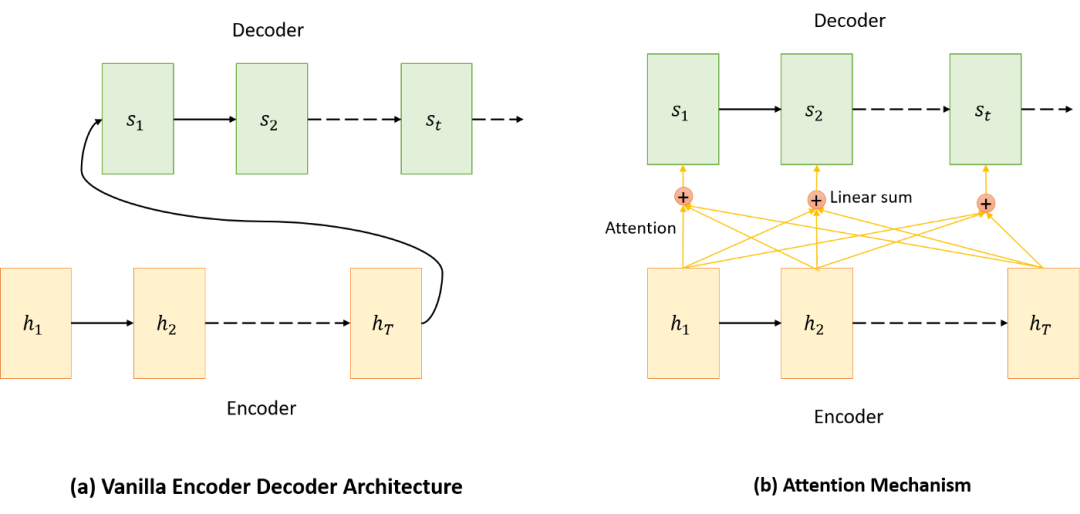

三种Transformer模型中,注意力机制介绍将自注意力作为独立机制整合,使得RNNs不再必要。 图2:注意力机制可视化 自注意力允许模型通过整合上下文信息来增强输入嵌入,使其能够动态地权衡序列中不同元素的重要性。这一特性在NLP中尤其有价值,因为词语的含义往往随其在句子或文档中的上下文而变化。 尽管已提出多种...

清华大学申请人工智能技术专利,解决了相关技术在进行注意力机制的...清华大学申请一项名为“高效支持稀疏注意力机制的软硬件协同加速方法及装置“,公开号CN117687787A,申请日期为2023年12月。专利摘要显示,本申请涉及人工智能技术领域,特别涉及一种高效支持稀疏注意力机制的软硬件协同加速方法及装置,其中,方法包括:获取自注意力矩阵;对自...

飞飞加速器部分文章、数据、图片来自互联网,一切版权均归源网站或源作者所有。

如果侵犯了你的权益请来信告知删除。邮箱:xxxxxxx@qq.com

上一篇:注意力机制和自注意力机制区别

下一篇:注意力机制和自注意力机制