注意力机制和自注意力机制哪个好_注意力机制和自注意力机制哪个好

*** 次数:1999998 已用完,请联系开发者***

⊙ω⊙ 久其软件:公司尚在研究DeepSeek提出的稀疏注意力机制金融界2月21日消息,有投资者在互动平台向久其软件提问:您好,近日DeepSeek创始人亲自率队,提出了革命性注意力机制NSA,具体来说,它是一种面向硬件且支持原生训练的稀疏注意力机制(Sparse Attention),专为超快长上下文训练与推理设计。贵司于今年2月10日在互动平台表示在大模...

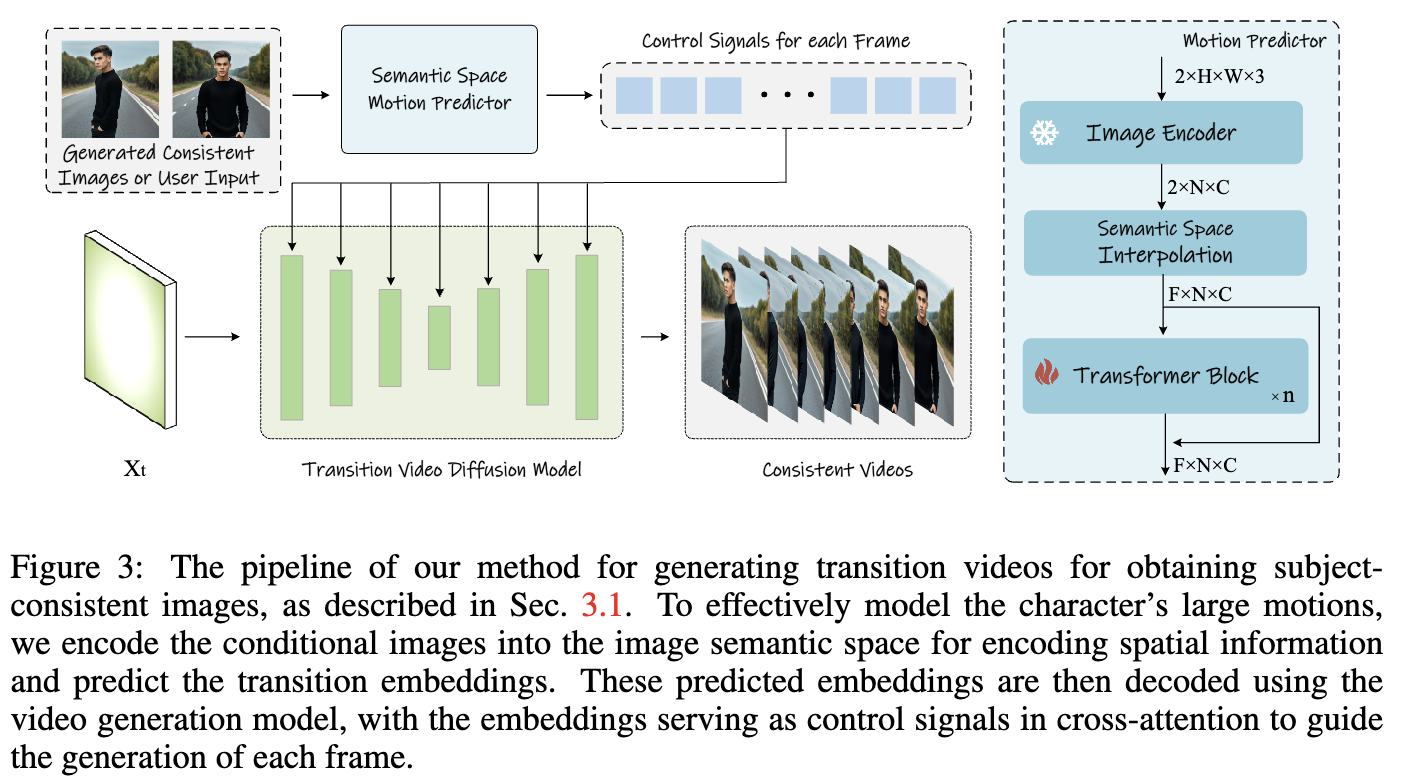

AI绘画中,Transformer的“自注意力机制”有什么作用?Transformer的自注意力机制和位置编码发挥了关键作用。 AI绘图模型大量使用了自注意力机制训练,用于提取和生成更加准确符合文本提示的图片: 自注意力机制就像是一个超级聚光灯,能够照亮文本中最重要的信息。当我们阅读一段话时,自然会关注其中的关键词,而忽略不相关的部...

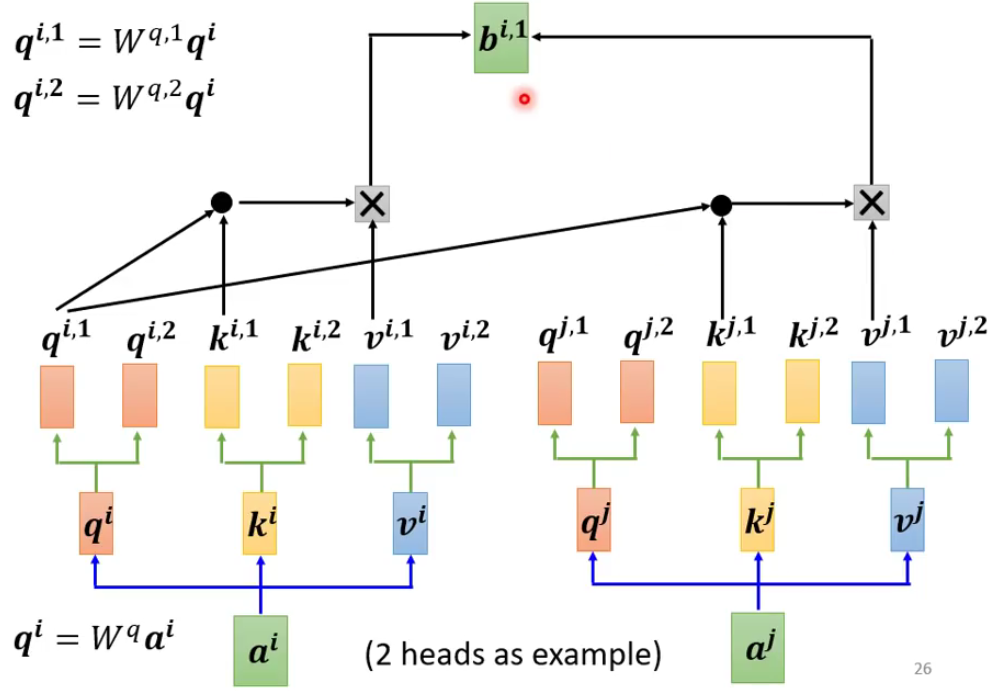

一文明白什么是自注意力机制,还不快来学自注意力(Self-Attention),也被称为内部注意力(Intra-Attention),是一种注意力机制,它允许模型在同一个序列内的不同位置之间进行直接的交互和关联。这种机制使得模型能够捕捉序列内部的长距离依赖关系,无论这些依赖关系的实际距离有多远。 在自注意力机制中,每个序列元素都会生成...

国网(山东)电动汽车服务申请基于概率稀疏自注意力机制的充电桩故障...金融界2024年10月28日消息,国家知识产权局信息显示,国网(山东)电动汽车服务有限公司申请一项名为“一种基于概率稀疏自注意力机制的充电桩故障检测方法”的专利,公开号CN 118821031 A,申请日期为2024年9月。专利摘要显示,本发明提出了一种基于概率稀疏自注意力机制的充电...

∩0∩

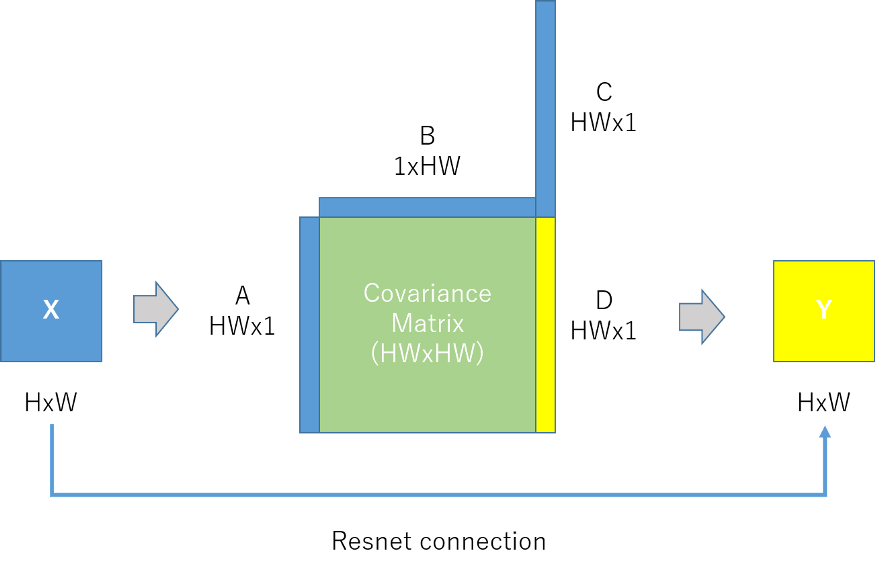

海康威视获得发明专利授权:“一种自注意力机制计算方法、推理方法”证券之星消息,根据天眼查APP数据显示海康威视(002415)新获得一项发明专利授权,专利名为“一种自注意力机制计算方法、推理方法”,专利申请号为CN202410852330.7,授权日为2024年8月27日。专利摘要:本申请实施例提供了一种自注意力机制计算方法、推理方法,该方法包括:基于...

算法人生(20):从“自注意力机制”看“个人精力怎么管”自注意力和前馈网络层的计算:在编码器和解码器的每个层中,分别执行多头自注意力机制和全连接前馈网络的计算,以生成新的表示。最终输出:解码器的最后一层的输出经过一个线性层和 Softmax 函数,生成最终的预测结果或者生成序列。在上述步骤中,自注意力机制起到的作用主要是将...

∪▽∪ ...知识图谱和时序自注意力机制实现级联测试自动化,减少所耗费的工作量获得同一时刻的预测特征向量与特征向量的相似度,更新得到文本图谱映射模型;获取与待测试业务对应的约束向量输入更新后的文本图谱映射模型进行处理,得到测试请求报文图谱,解码得到测试报文用来测试。通过采用知识图谱和时序自注意力机制实现级联测试自动化,减少所耗费的工...

?▂?

三种Transformer模型中,注意力机制介绍本文深入探讨Transformer模型中三种关键的注意力机制:自注意力、交叉注意力和因果自注意力。这些机制是GPT-4、Llama等大型语言模型(LLMs)的核心组件。通过理解这些注意力机制,我们可以更好地把握这些模型的工作原理和应用潜力。 我们不仅会讨论理论概念,还将使用Python和...

╯▂╰ 清华大学申请人工智能技术专利,解决了相关技术在进行注意力机制的...清华大学申请一项名为“高效支持稀疏注意力机制的软硬件协同加速方法及装置“,公开号CN117687787A,申请日期为2023年12月。专利摘要显示,本申请涉及人工智能技术领域,特别涉及一种高效支持稀疏注意力机制的软硬件协同加速方法及装置,其中,方法包括:获取自注意力矩阵;对自...

●﹏●

∪0∪ 天翼云科技申请基于注意力机制的时空图卷积网络客流量预测方法专利...本发明公开了一种基于注意力机制的时空图卷积网络客流量预测方法,包括:客流量数据预处理输入、利用时间注意力机制和空间注意力机制捕捉客流量序列的依赖性、构建时空卷积块、时空图模型搭建、模型训练和客流量预测;其有益效果为:通过将时间注意机制与时空卷积结合,获取站...

飞飞加速器部分文章、数据、图片来自互联网,一切版权均归源网站或源作者所有。

如果侵犯了你的权益请来信告知删除。邮箱:xxxxxxx@qq.com

上一篇:注意力机制和自注意力机制哪个好

下一篇:注意力机制和自注意力机制