注意力机制建模_注意力机制建模

*** 次数:1999998 已用完,请联系开发者***

提升长序列建模效率:Mamba+交叉注意力架构完整指南本文将深入分析Mamba架构中交叉注意力机制的集成方法与技术实现。Mamba作为一种基于选择性状态空间模型的新型序列建模架构,在长序列处理方面展现出显著的计算效率优势。通过引入交叉注意力机制,Mamba能够有效处理多模态信息融合和条件生成任务。本文从理论基础、技...

ˇ0ˇ

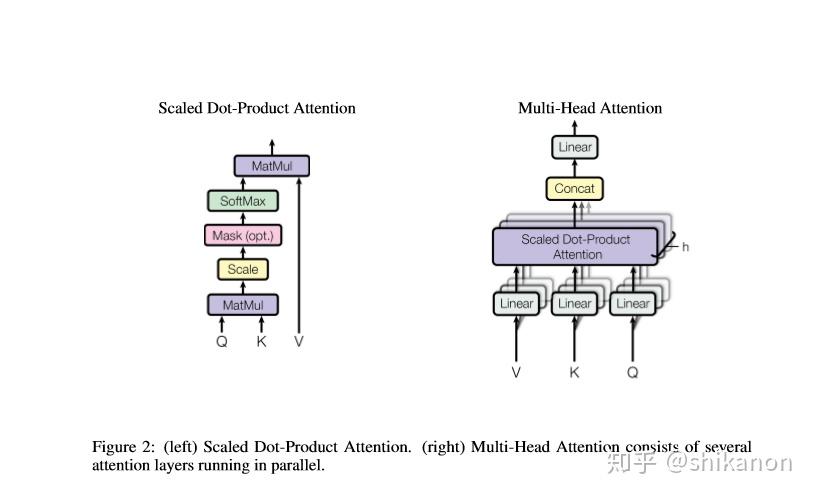

Transformer:从原理到序列建模的核心引擎在自然语言处理的革命中,Transformer 以 “注意力机制” 为核心,彻底改变了序列建模的范式。它摆脱了循环神经网络(RNN)对时序依赖的束缚,通过并行计算大幅提升效率,不仅成为 BERT、GPT 等大模型的基础架构,更在机器翻译、文本生成等领域掀起颠覆性变革,重新定义了人工智能...

∩▽∩

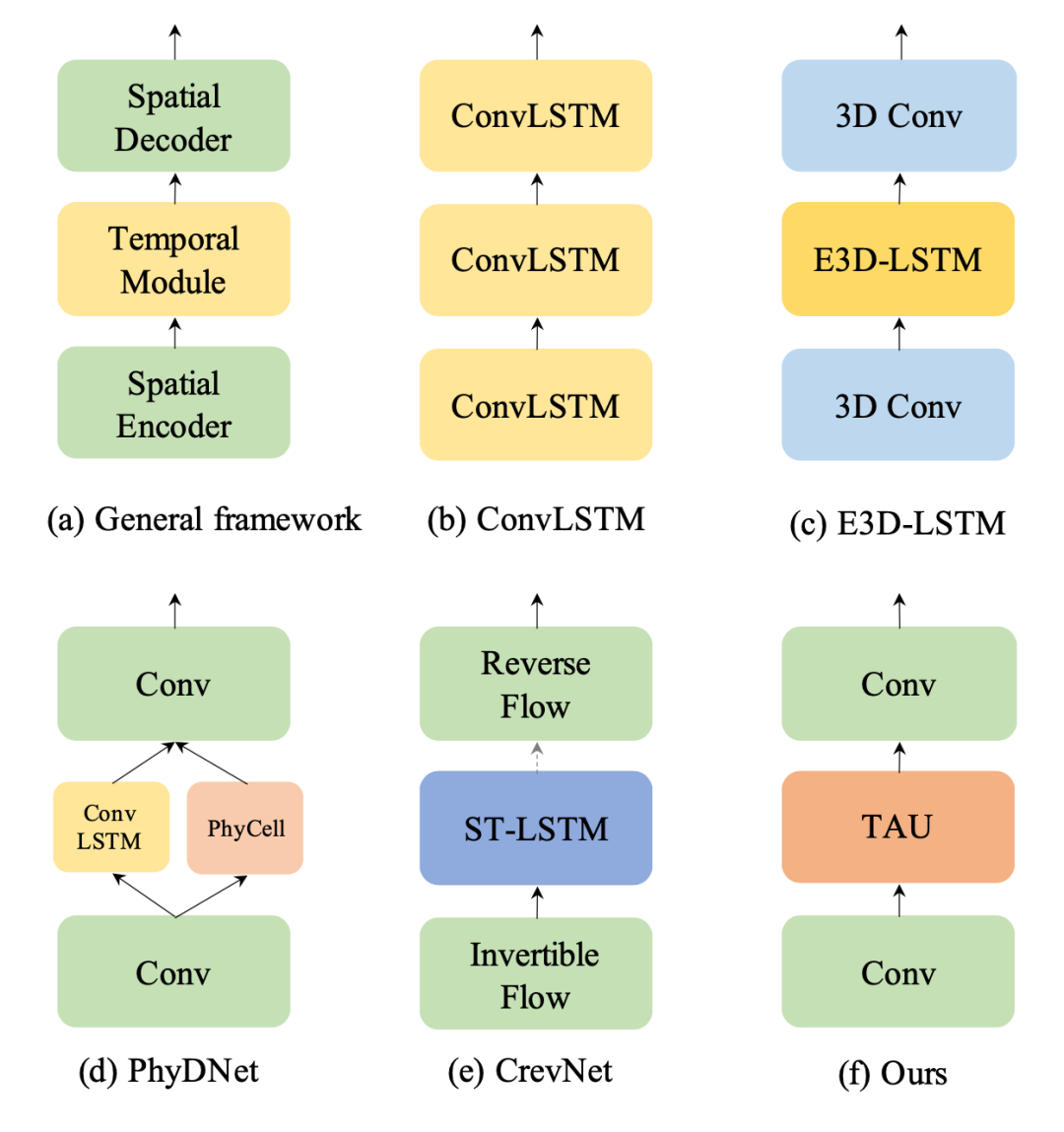

∩0∩ 年终巨献|业内首创功能大揭秘,Tec-Creative 2.0 “爆款力”全升级年终岁末一键爆款“神器” Tec-Creative 2.0正式上线2个月后迎来全新功能升级大礼包一键无中生有,爆款无限裂变让无边想象跃然眼前,5大新功能先睹为快!01效果对标Sora“视频生成”大升级大幅度的合理运动视频生成Tec-Creative 2.0 采用3D时空联合注意力机制,能够更好地建模视...

DeepSeek发布新论文:梁文锋亲自参与并提交论文标题为“Native Sparse Attention: Hardware-Aligned and Natively Trainable Sparse Attention”(原生稀疏注意力:硬件对齐和原生可训练的稀疏注意力)。论文链接:https://arxiv.org/abs/2502.11089摘要如下:长上下文建模对下一代大语言模型至关重要,但标准注意力机制的高计算成本带...

飞飞加速器部分文章、数据、图片来自互联网,一切版权均归源网站或源作者所有。

如果侵犯了你的权益请来信告知删除。邮箱:xxxxxxx@qq.com

上一篇:注意力机制建模

下一篇:注意力机制和注意力模型