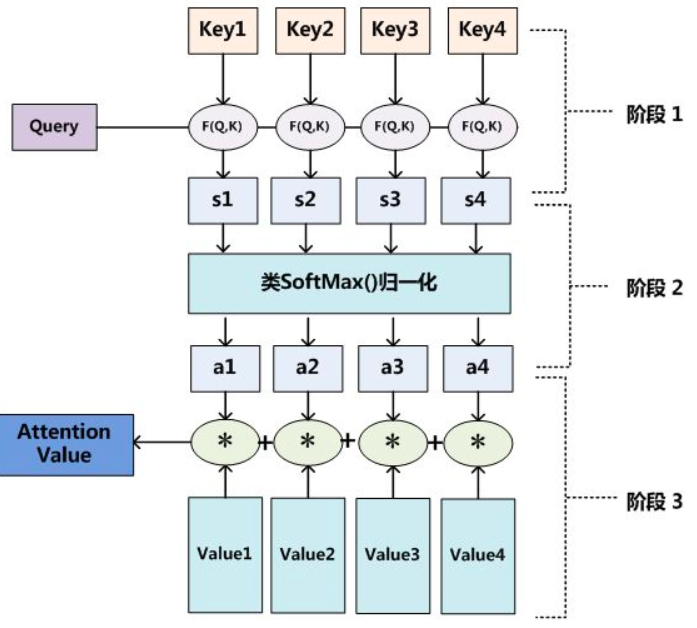

注意力机制的神经网络架构

时间:2025-11-04 17:06 阅读数:1343人阅读

*** 次数:1999998 已用完,请联系开发者***

˙﹏˙ 机器视觉非接触式检测系统:工业制造的智能新宠结合卷积神经网络与Transformer架构,实现高鲁棒性与高泛化能力协同优化。如表面缺陷检测,模型借注意力机制聚焦微小裂纹等区域,结合上下文排除噪声,自监督学习还降低对人工标注依赖。 深圳虚数的DLIA工业缺陷检测系统在复杂多目标优化场景展现强大智能决策优化能力。工业生...

∩▽∩ Transformer:从原理到序列建模的核心引擎在自然语言处理的革命中,Transformer 以 “注意力机制” 为核心,彻底改变了序列建模的范式。它摆脱了循环神经网络(RNN)对时序依赖的束缚,通过并行计算大幅提升效率,不仅成为 BERT、GPT 等大模型的基础架构,更在机器翻译、文本生成等领域掀起颠覆性变革,重新定义了人工智能...

⊙﹏⊙‖∣°

∩0∩ 从零学习大模型(5)——位置编码:让 AI 读懂 “语序” 的关键技术在 Transformer 架构中,有一个容易被忽略却至关重要的模块 —— 位置编码(Positional Encoding,PE)。如果说注意力机制让模型能 “理解关联”,前馈神经网络让模型能 “提纯特征”,那么位置编码的作用就是让模型能 “感知顺序”。人类语言中,语序直接决定语义:“我打了你” 和 “你...

飞飞加速器部分文章、数据、图片来自互联网,一切版权均归源网站或源作者所有。

如果侵犯了你的权益请来信告知删除。邮箱:xxxxxxx@qq.com

上一篇:注意力机制的神经网络架构

下一篇:东方网络ssr节点