注意力机制的可解释性

时间:2025-06-09 18:18 阅读数:7395人阅读

*** 次数:1999998 已用完,请联系开发者***

˙▂˙ MiniMax挑战Transformer架构,要做AI agent时代的新基建?业内称没有...第一次大规模实现线性注意力机制,直接挑战传统的Transformer架构,再一次在行业掀起巨浪。某大模型领域专家对记者解释,“传统的Transformer的注意力机制的计算复杂度随着序列长度的增加而呈二次增长,所以做长文本效率很低。MiniMax一直在做’线性注意力机制’这一套,做了比...

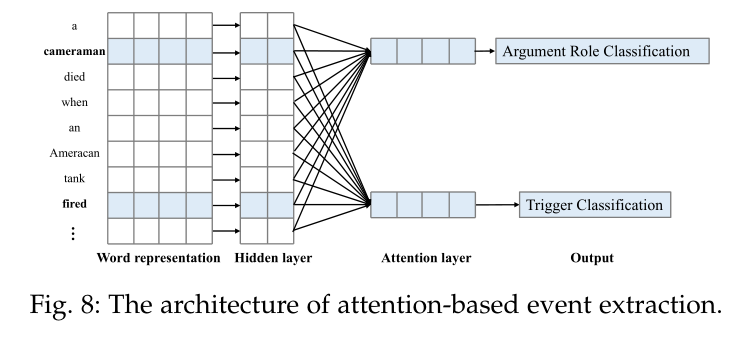

微软清华改进Transformer:用降噪耳机原理升级注意力只有少数token会真正影响当前token的含义。而注意力机制允许每两个词之间产生交互,其中就包含大量噪声了。团队提出的方法是在注意力层中增加一个Softmax,然后两个Softmax做减法。这一减,噪音信息就被大幅抵消,让注意力更集中在相关内容上。语言建模任务上的一系列实验结果...

470 报仇?欢声笑语不断自然是非常有意思。 只是这都快过去半个小时了,孙娇娇这一个队伍依旧还没有下场。 因为只要能接住沙包就能够加一条命或是救一个人的机制,以至于孙娇娇这个队伍人员是上下场不断来回,可能刚下场没两分钟又可以上场了。 这下子所有人的注意力都集中在了孙娇娇的...

飞飞加速器部分文章、数据、图片来自互联网,一切版权均归源网站或源作者所有。

如果侵犯了你的权益请来信告知删除。邮箱:xxxxxxx@qq.com

上一篇:注意力机制的可解释性

下一篇:如何在国内facebook